Des intelligences artificielles lisent désormais sur les lèvres

Des intelligences artificielles lisent désormais sur les lèvres

DeepMind, qui appartient à Google, a développé un programme informatique capable de lire sur les lèvres de façon plus efficace que les humains.

Deux programmes capables de lire sur les lèvres ont été dévoilés le même mois. | QUENTIN HUGON/Pixels

C’est une nouvelle réussite pour Google DeepMind, l’entreprise d’intelligence artificielle londonienne rachetée par Alphabet. En début de semaine, ses chercheurs ont annoncé, avec des scientifiques de l’université d’Oxford, avoir développé un programme capable de lire sur les lèvres plus efficacement que les professionnels humains.

Dans un article de recherche, ils expliquent que cette technologie d’intelligence artificielle réussit à lire sur les lèvres 46,8 % du temps, alors qu’un professionnel ayant dix ans d’expérience, soumis au même test, y parvient 12,4 % du temps.

5 000 heures de vidéo

Pour que la machine parvienne à ce résultat, les chercheurs l’ont « entraînée » avec 5 000 heures de vidéos issues d’émissions politiques et d’actualité de la chaîne britannique BBC, couplées à des sous-titres. La machine s’est servie de ces exemples pour apprendre à lire sur les lèvres, grâce à la technologie du « deep learning » – la même qui a permis à DeepMind de concevoir un programme capable de battre l’humain au jeu de go. En tout, les vidéos qui lui ont été soumises contenaient 118 000 phrases différentes composées de 17 500 mots.

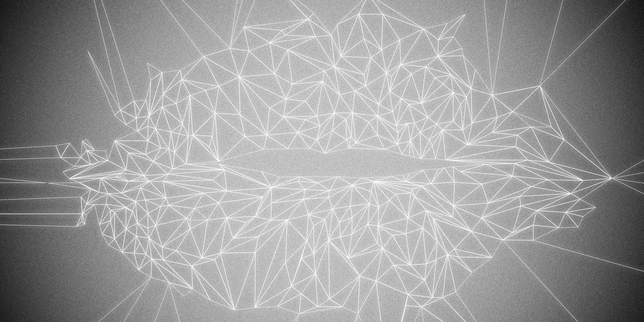

Plus tôt dans le mois, une autre équipe de chercheurs d’Oxford avait elle-même dévoilé un programme du même type, appelé LipNet. Si son efficacité est impressionnante (93,4 % de réussite, contre 52,3 % pour l’humain), c’est que le matériau de base était beaucoup moins complexe que celui utilisé par DeepMind. LipNet fonctionne en effet sur des vidéos entièrement conçues pour lui, dans lesquelles des êtres humains, de face, prononcent des phrases de trois secondes, d’une structure toujours identique et avec quelques dizaines de mots seulement – ce qui explique ces scores de réussite très élevés, tout comme ceux de l’humain. Voici ce à quoi ressemblent ces vidéos :

LipNet: How easy do you think lipreading is?

Durée : 01:44

Le programme de DeepMind, quant à lui, a travaillé sur des vidéos qui n’ont pas été pensées pour lui, sélectionnées dans des émissions de télévision classiques.

Malentendants et surveillance

A quoi peuvent donc servir de telles technologies ? Les chercheurs expliquent qu’elles pourraient aider les personnes malentendantes à comprendre les conversations. Si les logiciels de reconnaissance vocale sont déjà très efficaces pour retranscrire un discours, ils fonctionnent toutefois moins bien dans un environnement bruyant, contrairement aux technologies dévoilées par DeepMind et Oxford. Les scientifiques évoquent aussi la possibilité, à l’avenir, d’interagir avec des assistants vocaux, comme Siri ou Cortana… mais sans utiliser la voix. Ce qui pourrait servir, estiment-ils, quand l’utilisateur ne veut pas déranger les gens qui l’entourent.

Toutefois, ce type de technologie pourrait aussi être utilisé, à terme, à des fins de surveillance, puisqu’elle permet de comprendre ce que dit une personne même sans micro. Les chercheurs affirment que leur programme ne fonctionne que dans certaines conditions, et que la définition d’une caméra de surveillance est insuffisante pour qu’il comprenne correctement les mots prononcés, sur des images souvent sombres et des personnages lointains. Mais jusqu’à quand ?