Contributions au « grand débat » : comment analyser 68 millions de mots en deux semaines ?

Contributions au « grand débat » : comment analyser 68 millions de mots en deux semaines ?

Par Maxime Ferrer, Claire Legros

L’analyse des textes déposés sur le site du grand débat soulève de nombreuses questions de méthode. Des initiatives citoyennes et universitaires s’organisent en parallèle de l’analyse officielle.

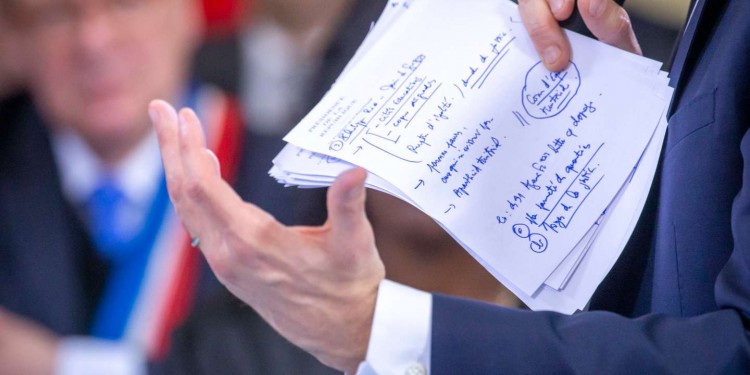

Emmanuel Macron, président de la République, participe au grand débat face aux élus de banlieue à Evry-Courcouronnes (Essonne), lundi 4 février. / JEAN-CLAUDE COUTAUSSE / FRENCH-POLITICS POUR "LE MONDE"

« Il fallait saisir cette opportunité. » Dès son annonce, Jean-François Gervais, retraité de 65 ans domicilié dans les Pyrénées-Atlantiques, s’est pris jeu du « grand débat national ». Le 23 janvier, il organise une réunion sur le thème de la finance à Saint-Jean-de-Luz. Et sur le site Internet du grand débat, il dépose en quelques semaines 41 « contributions ». « C’est une sorte d’inventaire à la Prévert de propositions. J’ai fait des titres synthétiques mais je n’ai pas répondu aux questions, un peu par facilité », avoue-t-il.

Parmi ses « contributions », on trouve en effet de nombreux titres explicites, comme « élire 50 % des députés à la proportionnelle » ou « moduler la taxe foncière en fonction du bilan énergétique du bâtiment ». Mais peu de détails sur ses idées, noyées dans la masse des données publiques des contributions au grand débat.

250 000 contributions, 68 millions de mots

Ces données, que Le Monde a pu examiner, révèlent qu’à ce jour 122 309 comptes ont été créés sur le site Internet du grand débat. Environ 250 000 contributions y ont été déposées, soit en moyenne un peu plus de deux par personne.

Ces contributions qui prennent la forme d’un questionnaire auquel le contributeur donne un titre combinent au total 94 questions dont 72 sont des champs de libre expression, sans contrainte de longueur, orientés par une question. Le Monde a comptabilisé un peu plus de 3 millions de textes effectivement écrits, pour un total de 68 millions de mots – soit 45 fois A la recherche du temps perdu, de Marcel Proust, ou 132 fois Les Misérables, de Victor Hugo.

Parmi les quatre thèmes proposés par le site, c’est celui de la finance qui a été le plus plébiscité, avec 71 727 personnes qui y ont déposé au moins une contribution, contre 58 035 pour la transition écologique, 45 068 pour une « organisation de l’Etat et des services publics » et 43 729 pour « démocratie et citoyenneté ». En définitive, seulement 12,8 % des contributeurs (15 607 personnes) ont répondu aux quatre thèmes de la consultation.

Les données seront traitées en moins de deux semaines

L’institut de sondage OpinionWay devra analyser en un temps record cette masse de données textuelles hétérogènes. Les contributions au grand débat seront closes le 18 mars et leur restitution publique est programmée pour fin mars, soit treize jours de délai.

OpinionWay a pour mission de classer les propositions mises en ligne afin de comptabiliser les différentes idées qui émergent. « Dans la mesure où il s’agit d’une consultation, pas d’un sondage, note Frédéric Micheau, directeur du département Opinion et politique, nous n’effectuons pas de pondération ni de redressement statistique pour assurer la représentativité de l’échantillon. »

A la fin, chacun des verbatims se verra associé une ou plusieurs catégories (« impôts », par exemple) ou sous-catégories (« augmenter les impôts », « baisser les impôts »), qui seront soumises au collectif des cinq garants, un collectif d’experts indépendants du gouvernement nommés par celui-ci pour « garantir l’indépendance du grand débat ».

Pascal Perrineau, professeur à Sciences-Po et garant du grand débat table sur « fin mars ou début avril pour un rendu définitif. La qualité du traitement des données est une vraie question. C’est la qualité de l’algorithme qui va faire la différence. »

Un algorithme pour classer les textes des contributions

Pour traiter ces données, l’institut de sondages a fait appel à l’entreprise française d’intelligence artificielle Qwam, spécialisée dans la veille sur le Web et l’analyse sémantique.

L’outil développé par Qwam va « lire » ou plutôt « analyser » les textes, en s’appuyant sur un « référentiel » de mots, de phrases et de concepts. « Notre solution de traitement sémantique, associée à l’intelligence artificielle, est capable de reconnaître le sens des mots dans une phrase pour classer les contributions en fonction des thématiques abordées : développement durable, augmentation du pouvoir d’achat… », explique le directeur général de Qwam, Christian Langevin.

Lorsqu’un mot présente plusieurs significations possibles, l’ingénieur assure que « le système reconnaît les contextes et peut deviner le sens d’un mot à 99 % en utilisant la technique de l’apprentissage profond [deep learning] ». Pour lui, pas de doute, « le traitement algorithmique est largement plus efficace que le traitement humain. » Lorsque le logiciel ne parvient pas à traiter l’information, une équipe reprend la main et assure un contrôle humain des contributions jugées ambiguës.

Selon une analyste d’un institut de sondage concurrent, « la méthode choisie n’est pas la bonne. Ils vont utiliser ce qu’on appelle un dictionnaire que l’on a préalablement nourri de termes à rechercher. Le problème avec cette méthode c’est qu’on n’est jamais sûr de ne pas passer à côté de l’essentiel. » En clair, on ne trouvera dans ce gigantesque corpus que ce qu’on y aura cherché, et la méthode choisie ne permettra pas de détecter l’émergence d’un thème inattendu.

« Le seul avantage est qu’ils pourront effectivement respecter les délais, poursuit cette analyste. Mais ça doit être frustrant et stressant de traiter ces données de cette manière car ils ne pourront pas aller au bout des choses. » Selon elle, le traitement d’un tel volume de données aurait nécessité « environ deux mois, en supposant d’y mettre des moyens humains et intellectuels considérables. »

Une consultation sujette aux biais

En laissant les internautes déposer autant de contributions qu’ils le souhaitent, des biais évidents planent sur les données qui seront collectées. A l’exception d’un code postal, aucune information n’est demandée aux contributeurs lors de leur inscription. Impossible donc de savoir si les individus qui ont pris part au grand débat sont plutôt des hommes ou des femmes, de connaître leur milieu social ou leur âge.

Pour Sébastien Delarre, sociologue à l’université de Lille-I, explique :

« Ne pas disposer des variables telles que l’âge ou la profession, c’est s’exposer à toutes sortes de biais venant de ce que les groupes sociaux ne vont pas se mobiliser de façon uniforme. On sait que ce type de dispositif a eu tendance à subir par le passé le noyautage de groupes coordonnés, très actifs, qui mettent en avant leurs thématiques favorites en spammant les outils de démocratie en ligne. »

Et la démonstration de cet état de fait est simple : en classant l’ensemble des textes saisis par les contributeurs selon leur fréquence, on retrouve assez facilement la trace d’un groupe mobilisé contre la limitation de la vitesse de circulation à 80 km/h sur les départementales. Les données montrent en effet qu’un modèle de 150 mots, posté sur des forums, a été copié et collé à l’identique au moins 4 500 fois par autant de contributeurs.

Des initiatives universitaires et citoyennes

Des associations et chercheurs ont commencé à se pencher, eux aussi, sur le traitement des données du grand débat. Dans une démarche de démocratie ouverte, la plate-forme Grandeannotation.fr, soutenue par le collectif Code for France, propose à tous ceux qui le souhaitent de participer à la catégorisation des contributions.

Chacun peut venir lire sur le site les propositions des internautes et les classer par thématiques, pour « faire émerger les idées les plus répandues et regrouper les réponses similaires », peut-on lire sur le site. Pour le moment, 142 personnes ont lu 106 987 contributions. « Si la masse de lecteurs qui annotent grossit, cela peut être intéressant en cas d’avis divergents, plusieurs lectures peuvent être sollicitées », expliquent les créateurs de la plate-forme dont le code est publié sous licence libre et accessible au public.

Selon le collectif, la liste des thématiques repérées par les contributeurs pourra aussi servir à « entraîner » les logiciels d’intelligence artificielle.

L’intelligence collective en complément de l’intelligence artificielle ? C’est aussi l’objectif de l’Observatoire des débats, lancé par un groupe de chercheurs, qui prévoit le suivi d’environ 60 débats par semaine, sélectionnés par tirage au sort. Quelque 170 chercheurs et étudiants, bénévoles, se sont inscrits pour assister à ces débats et remplir ensuite une grille d’observation sur les contenus des échanges et le public de la rencontre. Une « démarche de sciences participatives pour observer la méthodologie et la portée politique d’un débat d’une telle ampleur », indique Pierre-Yves Guihéneuf de l’Institut de la concertation et de la participation citoyenne (ICPC).

« Nous avions proposé au gouvernement d’être observateurs du grand débat mais nous n’avons pas eu de retour, explique Martine Legris, membre du groupement d’intérêt scientifique Démocratie et Participation. Nous nous sommes organisés pour produire une évaluation indépendante, à la fois du contenu et des méthodes. » Un premier bilan d’étape est prévu début avril.