Tuer un piéton ou sacrifier les passagers, le dilemme macabre des voitures autonomes

Tuer un piéton ou sacrifier les passagers, le dilemme macabre des voitures autonomes

LE MONDE SCIENCE ET TECHNO

Des psychologues ont testé les choix moraux des futurs utilisateurs des automobiles sans pilote.

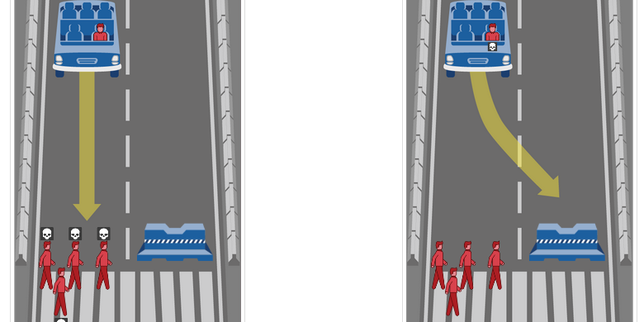

Au volant d’une voiture, devant vous, dix piétons traversent soudainement. Donnez-vous un coup de volant pour les éviter, quitte à vous fracasser contre un mur et à mourir, ou les percutez-vous pour épargner votre vie ? Ce dilemme cruel n’est pas simple à régler, même si de nombreuses études en psychologie ont montré depuis longtemps que les répondants privilégient l’hypothèse de leur sacrifice pour sauver plus de vies.

« Cela peut sembler un scénario abstrait et artificiel, mais nous avons réalisé que ces expériences de pensée philosophique pourraient devenir concrètes, car elles correspondent à des décisions qu’auront à prendre les véhicules autonomes », estime Azim Shariff (université de l’Oregon), un psychologue qui, avec deux collègues dans la revue Science, a remis au goût du jour cette question connue depuis 1967 sous le nom du dilemme du chauffeur de tramway.

Depuis 2012 et les premiers tours de roue de la voiture autonome de Google, tous les constructeurs automobiles s’y sont mis. Mais quel algorithme de pilotage faut-il privilégier pour guider ces voitures ? Celui choisissant le moindre mal ou celui préservant la vie de ses passagers ? Et, surtout, qu’en pense le propriétaire-passager ? Trois chercheurs du MIT, de l’université de l’Oregon et de l’Ecole d’économie de Toulouse ont désormais quelques réponses.

Classique des dilemmes sociaux

Ils ont procédé non par sondage, mais à l’aide d’expériences psychologiques en ligne consistant à donner son opinion devant des situations variées sur le nombre de piétons ou les liens familiaux ou amicaux avec le passager. Six tests ont été menés pendant six mois en 2015 auprès de 1 928 personnes recrutées grâce à la plate-forme Mechanical Turk d’Amazon.

Sans surprise, les participants répondent conformément à la littérature scientifique : pour sauver dix piétons, ils sont 75 % à dire qu’il est plus moral que le véhicule sacrifie le passager. Cette proportion ne varie quasiment plus au-delà de dix personnes, mais elle est plus faible dans le cas où les piétons sont moins nombreux.

En revanche, cette position morale fléchit lorsque les tests mettent le participant en position d’être dans la voiture, voire avec des membres de sa famille. Les cobayes pouvaient mettre une note de 0 à 100 pour jauger telle ou telle proposition. La note est en moyenne de 70 pour le choix consistant à privilégier la voiture minimisant les pertes, quand le cobaye est le seul passager. Elle tombe à 60 lorsqu’il est accompagné de membres de sa famille.

Elle chute encore à près de 40 dès lors qu’il s’agit d’indiquer sa propension à acheter une telle voiture. Les participants ont en fait tendance à préférer une voiture qui les protège, plutôt que prête à les sacrifier.

« C’est un classique des dilemmes sociaux, où l’intérêt égoïste peut passer avant l’intérêt collectif », observe Jean-François Bonnefon, l’un des coauteurs, chercheur à l’Ecole d’économie de Toulouse. Le paiement des impôts est un autre célèbre de ces dilemmes. « Mais la nouveauté est que pour la première fois ce choix se pose face à des objets programmés pour nous tuer, c’est-à-dire prêts à sacrifier le propriétaire ! », ajoute-t-il.

Régulation nécessaire mais contre-productive

Anticipant le développement de ces technologies, les chercheurs ont aussi voulu savoir si les régulateurs pouvaient agir pour favoriser ces voitures censées limiter de 90 % le nombre d’accidents comme rappelé dans leur article. « Pour résoudre les dilemmes sociaux, le rôle des gouvernements est d’assurer à chaque individu que tout le monde jouera le jeu. Il est donc tentant de rendre obligatoire des algorithmes “utilitaristes”, minimisant les pertes », précise Jean-François Bonnefon. Et il est tentant aussi d’estimer l’effet de telles mesures, ce que les chercheurs ont fait dans leurs deux derniers tests.

Le résultat est que les participants jugent assez mal l’idée de rendre obligatoire de tels programmes et encore plus d’acheter des véhicules ainsi équipés. La conclusion paradoxale s’impose, « la régulation pourrait être nécessaire mais contre-productive », écrivent les auteurs. En repoussant l’achat de ces véhicules, moins de vies seraient en effet sauvées. Avis donc aux législateurs.

Cependant, il n’est pas certain que cette expérience de psychologie leur soit si utile. « En réalité il y a peu de situations où de tels dilemmes se rencontrent. Le véhicule cherche à limiter les accidents et à anticiper. Elle limitera la casse de toute façon », souligne Jean-Gabriel Ganascia, spécialiste d’intelligence artificielle au laboratoire d’informatique de l’université Paris-VI.

Le 1er décembre 2015, dans le Washington Post, Chris Urmson, le responsable des véhicules autonomes chez Google, notait que ces dilemmes « sont des problèmes amusants pour des philosophes, mais, en temps réel, les humains ne réagissent pas comme cela ». Il constatait aussi que les ingénieurs cherchaient à éviter les collisions avec les usagers vulnérables de la route (cyclistes, piétons), puis les autres véhicules et enfin les objets qui ne bougent pas. La voiture ne peut décider quel sens cela aurait de toucher telle ou telle personne pour éviter une collision.

« Considérer la seule somme des différents maux schématise trop la situation et engendre des débats infinis. Faut-il tenir compte de l’âge des personnes, du fait qu’elles avaient ou non le droit d’être à cet endroit sur la route… Cela conduit à des calculs sans fin, estime Jean-Gabriel Ganascia. Cette schématisation est discutable du point de vue éthique. »

« Cela permet d’explorer et d’identifier des catégories de problèmes difficiles. Et aussi d’avoir une plus grande conscience des coûts et bénéfices de ces véhicules », note Jean-François Bonnefon. L’équipe n’en reste d’ailleurs pas là. Elle propose sur un site Internet, moralmachine.mit.edu, d’exprimer ces choix sur une variété de situations, voire d’en imaginer d’autres en fonction du sexe et de l’âge des personnes, de la présence d’un voleur, d’un médecin…